[프리즘] 책임 있는 사용을 위한 AI TRiSM (1)

페이지 정보

작성자 작성일 2024-06-03 10:26 조회 3,948 댓글 0본문

기대감의 정점에 선 생성 AI에 대한 우려

기업들은 생성 AI가 가져오는 기회와 함께 위험성도 인식하기 시작했다. 글로벌 컨설팅사, 맥킨지(McKinsey) 조사 에 따르면, 63%의 기업이 생성 AI를 활용하는 것을 “높은” 또는 “매우 높은” 우선순위로 꼽았다. 그러나 이 중

91%가 책임 있게 활용할 준비가 거의 되어 있지 않다며 AI의 편향된 판단이나 보안 사고

등 위험성에 대해 우려했다.

생성 AI를 활용하는 구성원들이 많아지고 있는 것도 주목할 이슈다. 세일즈포스(Salesforce) 조사 에 따르면, 전 세계 직장인의 28%가 생성 AI를 업무에 활용하고 있으며, 이 중 71%는 생산성을 높였다고 답했다. 그러나 생성 AI 사용자 중

55%는 공식적으로 승인되지 않은 생성 AI 툴을 사용한 적이 있고, 전체 응답자 중 79%는 기업 내 기술 활용에 대한 명확한 가이드라인과

방침이 부재하다고 답했다. 기업과 구성원 모두 AI 기술이

가져다 줄 이점을 기대하면서도, 위험성을 최소화할 필요성을 느끼고 있는 것으로 보인다.

안전하고 책임 있는 사용을 위한 AI TRiSM

가트너는 책임 있는 AI를 제공하기 위한 방법으로 ‘AI TRiSM’을 제시했다.

AI TRiSM란, ‘AI Trust, Risk, and Security

Management(AI 신뢰, 위험, 보안관리)’의 약자로, 끊임없이 진화하는

AI 기술에 대해 신뢰를 구축하고, 위험을 완화하며, 보안을

강화하도록 돕는 프레임워크를 의미한다. AI를 개발, 배포

및 활용하는 전 과정에 걸쳐 선행되어야 하는 안전장치라고 할 수 있다.

가트너는 2026년까지 AI TRiSM을 구현하는 조직은 AI에 대한 사용자 수용도와 비즈니스 목표 달성 측면에서 50% 개선시킬

수 있는 반면, 그렇지 않은 조직은 기술에 대한 불신, 데이터

유출, 브랜드 평판 손실 등 심각한 문제를 경험할 가능성이 기하급수적으로 높아질 것이라고 예측했다. AI 신뢰, 리스크, 보안

관리의 의미를 각각 살펴보자.

· AI 신뢰 구축: AI의 예측과 판단에 대한 사용자의 신뢰를 의미하며, 편견과 차별적 요소가 없도록 설계 및 구현되고, 어떻게 작동되는지에

대한 정보를 제공해야 한다. 예를 들어, AI가 의사에게

환자 질병을 진단하거나 치료에 대한 처방을 추천해주는 경우, 그 판단을 내린 근거를 설명할 수 있어야

한다.

#공정성 #윤리성 #투명성

· AI 위험 완화: AI 시스템을 성능 저하, 개인정보 침해, 기밀 정보 유출 등 잠재적 위험을 선제적으로 식별, 평가하고 완화하는 방식으로 설계, 구현하는 것이다. 이를 위해 AI 시스템의 거버넌스와 위험 관리 절차를 마련하고, 제도와 규정을 준수하고 있는지 확인한다. 마치 자율주행 자동차가

실수를 할 수 있다는 것을 인지하고, 이 실수가 사고로 이어지지 않도록 미리 조치를 취하는 것이다.

#거버넌스 #규정준수 #위험관리

· AI 보안 강화: AI 시스템을 사이버 공격이나 민감한 정보에 대한

무단 접근과 같은 위협으로부터 보호하는 것이다. AI 인프라부터, 데이터, 모델 등 수명주기 전반에 걸쳐 보안 취약성을 모니터링하고, 보호

조치가 준비되어 있는지 확인해야 한다. 예를 들어, AI가

금융 사기 행위를 탐지할 경우, 보안 프로토콜을 강화하고 암호화, 이상

현상 감지, 실시간 모니터링 등 기술을 활용해야 한다.

#사이버공격 #데이터보호

기업이 AI TRiSM을 준비해야 하는 이유

– AI TRiSM의 핵심 요소 4가지를 기준으로

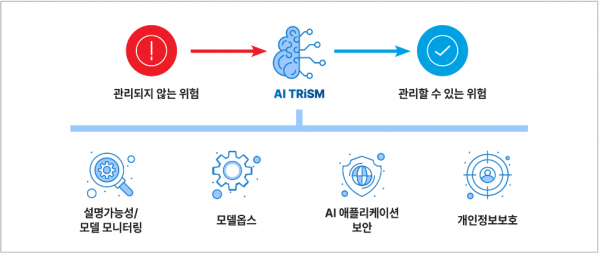

AI와 관련된 위험은 기술이 배포된 후에 드러나는 경우가 많다. 이전에

관리되지 않았던 위험을 관리할 수 있는 위험으로 전환하려면, AI TRiSM의 핵심 요소 4가지를 챙겨야 한다.

* Source: Gartner / IGM 재구성

1) AI 시스템의 설명가능성(Explainability)을 통해 의사결정에

도달하는 과정을 이해

생성 AI를 활용해본 사용자라면, AI의 답변의 출처가 궁금한 적이 있을

것이다. AI에게 출처를 요청하면, 잘못된 정보를 제공하거나, 찾을 수 없는 경우가 많다. AI 모델이 어떤 데이터를 사용하고, 어떻게 의사결정을 내리는지, AI 모델의 강점과 약점은 무엇인지, 향후 예상되는 동작은 무엇인지 명확히 설명할 수 있어야 한다.

이때

설명 가능한 AI(Explainable AI, XAI)와 지속가능한 모니터링과 같은 기술과 솔루션이

필요하다. 또한 모델을 훈련시키는 데 사용된 데이터셋과 데이터 선택 방법에 대한 정보가 있다면, 이를 공개함으로써 잠재적인 편향성을 드러낼 수 있다.

2) 모델옵스(ModelOps)를 통해 AI 수명 주기 관리

모델옵스는 AI 모델의 개발, 테스트, 배포, 모니터링 및 유지보수 등의 전체 작업을 관리하는 것을 의미한다. AI 모델을

자동화 및 모니터링하고, 거버넌스 규칙을 적용함으로써 지속 가능하게 사용할 수 있다.

3) AI 애플리케이션 보안(Security)을 통해 사이버 공격으로부터

보호

AI TRiSM은 AI 시스템을 둘러싼 인프라, 데이터 및 모델을 악의적인 공격과 무단 접근으로부터 보호하는 데 중점을 둔다.

강력한 보안 조치와 절차를 구현함으로써 기업은 민감한 데이터와 지적 재산을 보호하고 AI 시스템의

무결성을 유지할 수 있다.

4) 개인정보 보호(Privacy) 및 규제 변화에 대한 대응

AI 시스템은 방대한 양의 민감한 데이터를 처리하는 경우가 많다. AI

TRiSM을 통해 개인정보보호 기술을 적용하고, 데이터 수집을 최소화함으로써 개인정보보호

문제를 예방할 수 있다. 또한 전 세계적으로 AI 규제에

대한 관심이 높아짐에 따라 AI TRiSM을 구현하는 기업은 계속 진화하는 개인정보 보호법 및 규제에

빨리 적응하여 데이터 유출이나 재정적 손실과 같은 피해를 줄일 수 있다.

<References>

· “Navigating The Future With AI TRiSM For Secure Innovation”,

2024.1.3, Forbes

· “Our Responsible AI Pledge: Setting the Bar for Ethical AI”,

2023.10.17, Walmart

· “Gartner Says More Than 80% of Enterprises Will Have Used Generative

AI APIs or Deployed Generative AI-Enabled Applications by 2026”, 2023.10.11,

Gartner Newsroom

· "Tackling Trust, Risk and Security in AI Models",

2023.9.5, Gartner

· "Building a Value-Driving AI Strategy for Your Business",

Gartner

· “Managing the Risks of Generative AI”, 2023.6.6, Harvard Business

Revies

· “Digital Citizenship: Ethical Use of Data & Responsible Use of

Technology”, 2023.3.17, Walmart

· “Accelerating scientific discoveries with explainable AI: A breast

cancer example”, Abzu

· “교육도 안하고 생성형 AI 활용하라고? 세일즈포스 설문에서 드러난 기업 현주소”, 2023.12.11, 매일경제